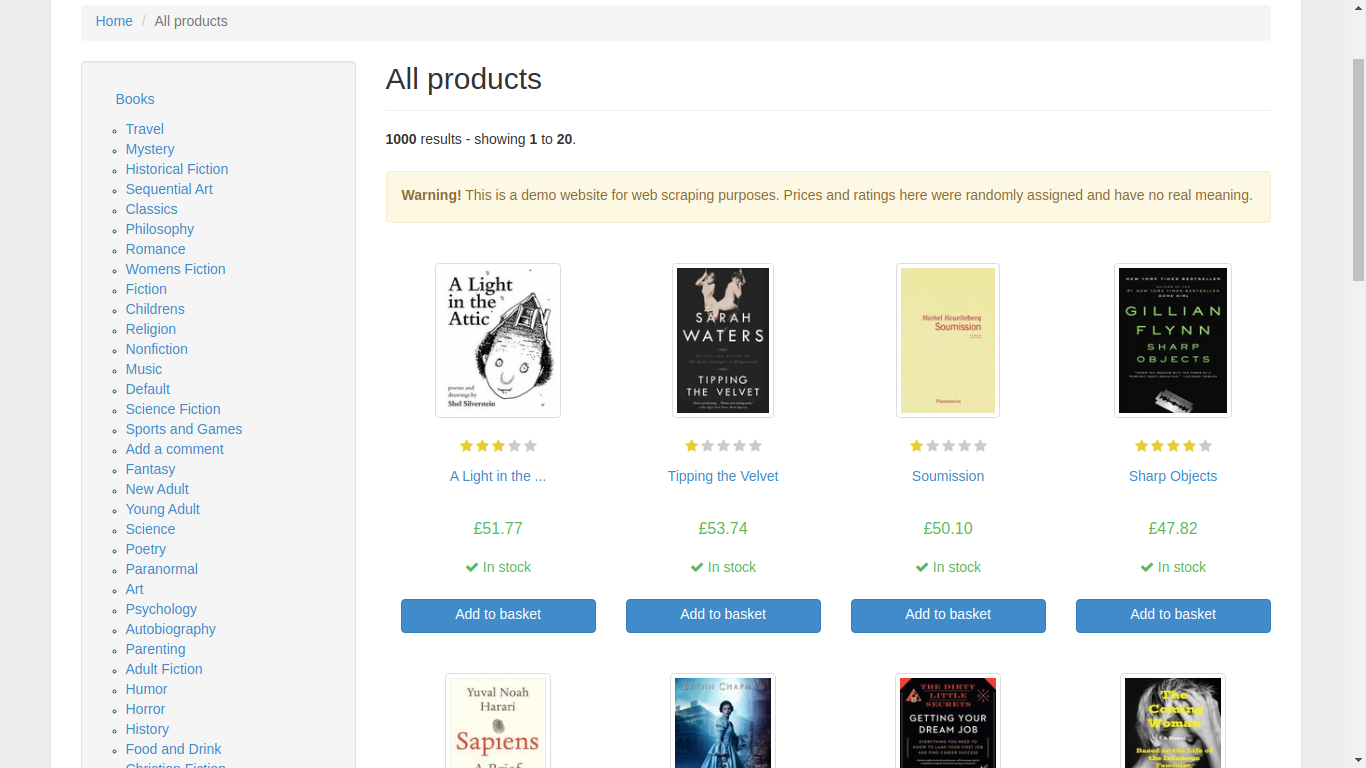

作者:巴德博·贝洛 软件工程师 作者选择了免费和开源基金作为“为捐赠而写”计划的一部分来接受捐赠。 介绍 网页抓取是从网络自动收集数据的过程。该过程通常会部署一个“爬网程序”,该爬虫会自动上网并从所选页面抓取数据。您可能想要抓取数据的原因有很多。首先,它通过消除手动数据收集过程使数据收集速度更快。当需要或需要数据收集但网站不提供 API 时,抓取也是一种解决方案。 在本教程中,您将使用 Node.js 和 Puppeteer 构建一个 Web 抓取应用程序。随着您的进步,您的应用将变得越来越复杂。首先,您将编写应用…

后羿采集器,基于人工智能技术,无需编程,可视化操作,免费导出采集结果,只需输入网址就能自动识别采集内容的数据采集工具。 简介 非结构化数据是指那些没有明确定义格式或结构的数据,通常以自由文本、多媒体内容、社交媒体帖子、图像、音频和视频等形式存在。与结构化数据(如数据库表)不同,非结构化数据的组织和解释通常需要更多的上下文和语境。

后羿采集器,基于人工智能技术,无需编程,可视化操作,免费导出采集结果,只需输入网址就能自动识别采集内容的数据采集工具。 简介 数据模型是数据的结构化表示,它描述了数据之间的关系、数据的属性以及如何组织、存储和操作数据。数据模型用于帮助理解数据的本质,为数据库设计、信息系统开发和数据分析提供指导。

后羿采集器,基于人工智能技术,无需编程,可视化操作,免费导出采集结果,只需输入网址就能自动识别采集内容的数据采集工具。 简介 增量采集是一种数据采集方法,它用于更新和维护现有数据,以反映数据源中的最新变化。这种方法与全量采集不同,全量采集是从头开始检索所有数据,而增量采集仅检索自上次采集以来发生的变化。

后羿采集器,基于人工智能技术,无需编程,可视化操作,免费导出采集结果,只需输入网址就能自动识别采集内容的数据采集工具。 简介 数据库管理系统(Database Management System,简称DBMS)是一种软件工具或系统,用于管理和维护数据库的创建、访问、更新和管理。数据库是一个组织数据的集合,而数据库管理系统则是管理这些数据的软件系统。

后羿采集器,基于人工智能技术,无需编程,可视化操作,免费导出采集结果,只需输入网址就能自动识别采集内容的数据采集工具。 简介 数据处理是将原始数据转化为可用信息的过程。在这一过程中,数据会经过清洗、转换、计算、分析等多个步骤,以便为决策制定、分析和报告提供有意义的结果。数据处理通常涵盖了从不同数据源中提取、清洗、整合和转化数据,使其能够被存储、分析和可视化。这对于从数据中获得洞察、做出明智的决策以及支持业务需求都至关重要。

后羿采集器,基于人工智能技术,无需编程,可视化操作,免费导出采集结果,只需输入网址就能自动识别采集内容的数据采集工具。 简介 数据整合是将来自不同数据源、格式或系统的数据合并和组织成一致、统一的数据集的过程。这有助于提供更全面、有意义和可用的数据,以支持数据分析、业务决策和报告。它涵盖了数据提取、数据转换和数据加载三个主要步骤。首先,数据被提取,这包括从各种数据源中收集数据。然后,数据经过转换,进行清洗、重构和标准化,以便使其适用于目标系统或工具。最后,经过转换的数据被加载到目标系统中,以供进一步的分析和应用。

后羿采集器,基于人工智能技术,无需编程,可视化操作,免费导出采集结果,只需输入网址就能自动识别采集内容的数据采集工具。 简介 数据采样是从大规模数据集中选择或提取一部分数据的过程,以代表整个数据集。采样的目的是减小数据量,使其更易于处理,同时保持对整体数据分布的代表性。数据采样是数据分析中的关键步骤,可根据具体分析需求和数据集特性采用不同的采样方法,如随机采样、分层采样、过采样和欠采样等。这些方法有助于更高效地处理大规模数据,同时保持对数据总体的有效代表性。

后羿采集器,基于人工智能技术,无需编程,可视化操作,免费导出采集结果,只需输入网址就能自动识别采集内容的数据采集工具。 简介 数据标准化是将不同度量单位、尺度和数据格式的数据转化为统一的标准格式的过程。数据标准化通常涉及到将数据缩放到特定的范围(例如0到1之间)或使用特定的标准分布(均值为0,标准差为1)。这有助于处理具有不同单位和度量尺度的数据,使它们适用于各种数据分析和建模技术。数据标准化包括两个主要步骤:数据清洗(数据清洗)和数据规范化(数据规范化)。数据清洗通常用来删除重复、无效或不必要的数据;数据规范化则…